1. OS版本确认

1.1. 版本查看

要求:计算机,属性,查看版本(1070,构建号>= 101.100)

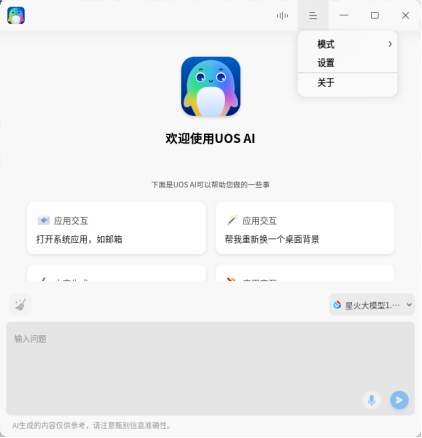

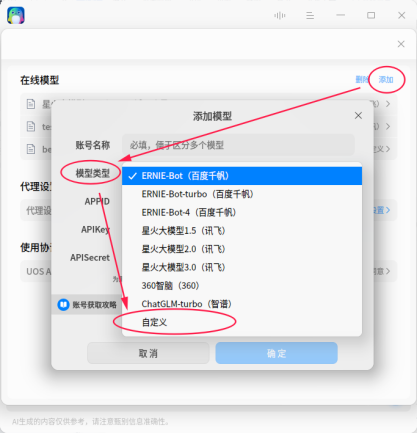

2. UOS AI版本确认

UOS AI,设置,点击添加,查看是否有:自定义,功能菜单(因为此操作需进行自定义配置)

3. 安装模型管理工具Ollama

3.1. Ollama简介

Ollama是一个开源的 LLM(大型语言模型)服务工具,用于简化在本地运行大语言模型,降低使用大语言模型的门槛,使得大模型的开发者、研究人员和爱好者能够在本地环境快速实验、管理和部署最新大语言模型,包括如Llama 3、Phi 3、Mistral、Gemma等开源的大型语言模型。官网:https://ollama.com/

3.2. Ollama安装

快速命令安装:curl -fsSL https://ollama.com/install.sh | sh

其它更多安装方式,可参照:https://github.com/ollama/ollama

4. 选择并安装模型

使用llama3.1模型:ollama run llama3.1

更多模型选择:https://ollama.com/library

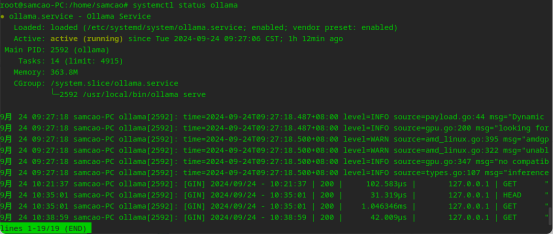

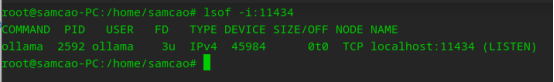

5. Ollama服务确认

systemctl status ollama

其它常用命令:

启动Ollama

#ollama server

下载模型

#ollama pull XXX(模型名称)

运行模型

#ollama run XXX(模型名称)

查看已下载模型

#ollama list

查看Ollama版本

#ollama --version

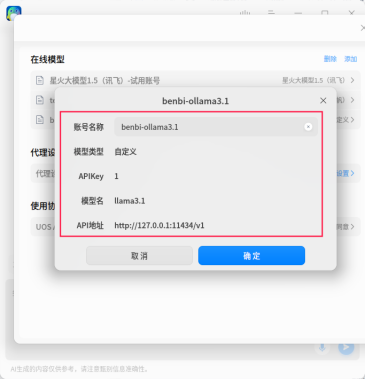

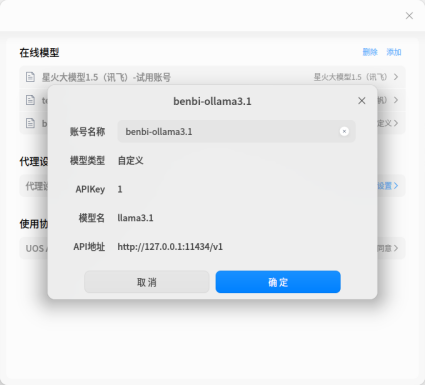

6. UOS AI关联配合模型

UOS AI,设置,点击添加,自定义

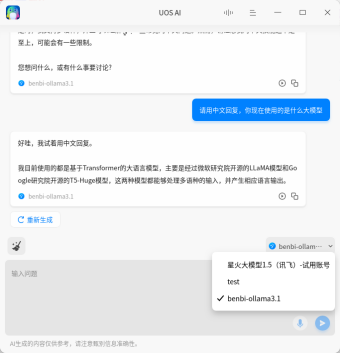

7. 测试

UOS AI本地大模型测试:

8. 其它

1、Ollama服务关闭开机启动:systemctl disable ollama

2、其它的可以参照:systemctl 的命令

综上:UOS 1070U1 的AI配置本地大模型。后续将进一步更新本地模型学习等内容。

©统信软件技术有限公司。访问者可将本网站提供的内容或服务用于个人学习、研究或欣赏,以及其他非商业性或非盈利性用途,但同时应遵守著作权法及其他相关法律的规定,不得侵犯本网站及相关权利人的合法权利。除此以外,将本网站任何内容或服务进行转载,须备注:该文档出自【faq.uniontech.com】统信软件知识分享平台。否则统信软件将追究相关版权责任。